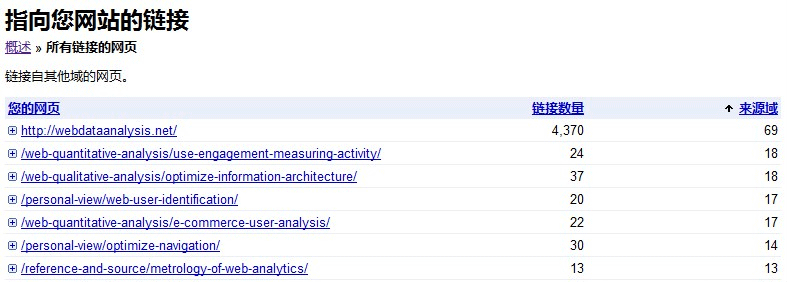

其实网站分析中很重要的一块就是网站的关键转化路径分析,可能很多的网站分析师在这一方面都倾注了大量的时间和精力,尽最大的努力寻找最优的转化路径,因为优化关键转化路径相当于提高转化率,进而提高网站收益。所以,尤其对于电子商务网站或者付费服务网站而言,关键转化路径分析尤为重要。之前的文章——网站转化率与漏斗模型对关键路径的定义和分析做过简单介绍,同时推荐了一个非常形象的数据展现方式——漏斗模型,能够让每一步的转化看起来一目了然。

既然对关键路径和转化率的定义和计算已经做过介绍,这篇文章不再累赘,这里只是想分享一下近段时间在统计关键路径的数据时对数据表现出的特征的一些感受,不知道跟大家日常看到的想到的是否一样。

其实对网站转化路径的优化无非就是一句话:简化、多样化关键转化路径。

简化转化路径

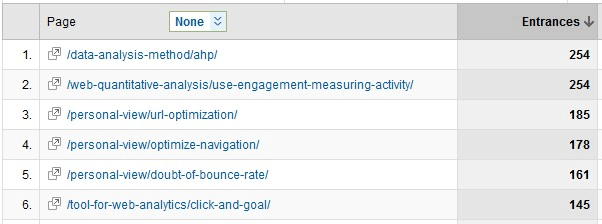

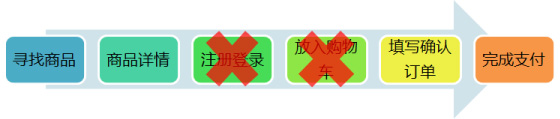

简化转化路径是近些年在关键转化路径分析优化方面讨论的较多的,同时大部分网站也都是朝这个方向在做,也带来了不错的效果。简单看一下电子商务网站转化路径的简化流程:

首先是把放入购物车作为了可选步骤,而不是必需步骤,购物车可以为购买多种商品的顾客带来方便,因为可以统一下单,也就是只需要完成一次订单填写和确认的工作;而对于只购买了一样商品的用户而言,显然放入购物车步骤是一个累赘,直接拿着商品结账就完了。

再者就是前段时间网上讨论很多的对注册和登录步骤的简化,用户选择购物和选择成为网站的会员完全是两码事,为什么买东西就一定要先注册成为网站用户?就像你去超市买东西为什么一定要办一张会员卡。当然注册成为网站会员可以为你下次的购买带来不少的方便,对于网站而言,只有用户注册才能构建器网站完整的CRM系统,实现用户的跟踪分析和用户的保留,所以一度注册登录是网上购物的必需步骤。但随着去年团购网站的纷纷涌现,用户对去每个网站消费都要注册一遍感到了厌烦,于是就有了简化注册的讨论,毕竟给网站带来直接利益的还是用户的购买行为,没有必要因为注册步骤的存在而引起潜在消费用户的流失。

多样化转化路径

其实上面说的“放入购物车”从必需的步骤到可选的步骤就是一个转化路径多样化的实现,这种灵活的选择同时满足了购买单独商品和购买多种商品的用户需求;但这里要说的是另一种多样化的形式。

先简单再看下上面的转化步骤,有哪几个是必需的步骤?商品、订单和支付,这3个分别代表了信息流、物流和资金流,是必需的(对于某些不需要物流的虚拟商品而言,订单步骤也是可以省略的,这里不考虑这类商品)。所以最简单的转化路径应该是:

跟上面简化后的步骤比较下:

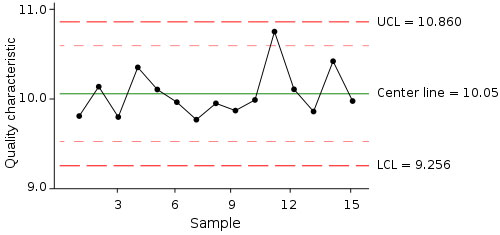

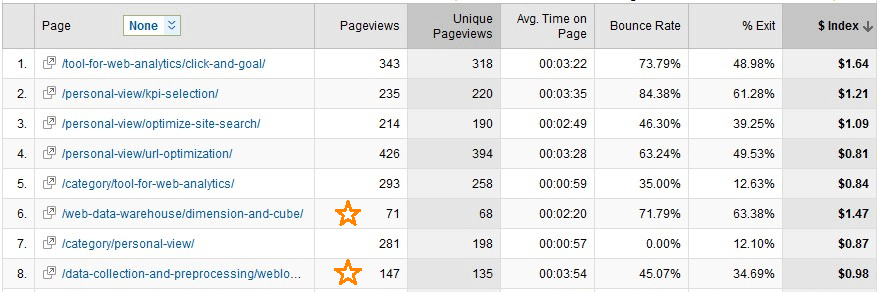

少了一个浏览商品详情页面的步骤,我们先不去讨论这个步骤到底是否是必需的,先看下数据能告诉我们什么?

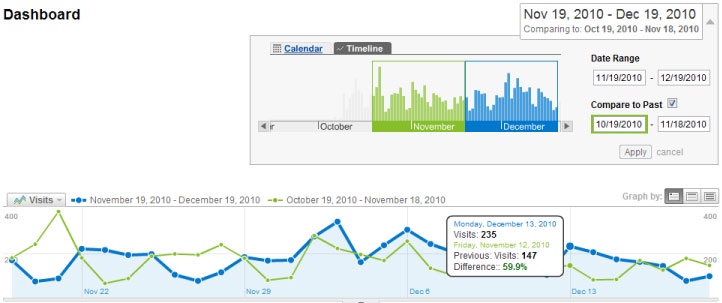

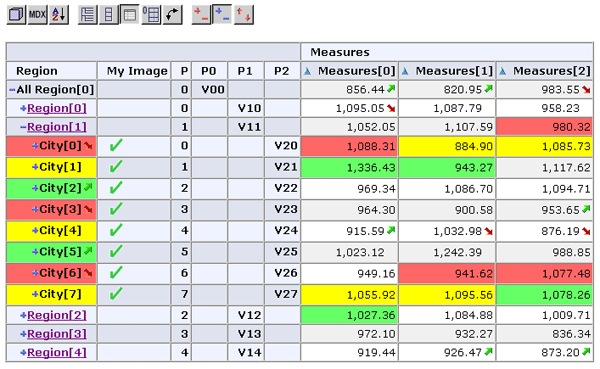

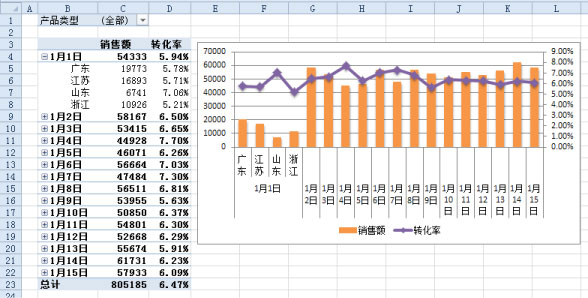

刚好公司的产品同时提供了以上的两种转化路径,可以通过数据来分析一下这两种路径哪个更加有效。不妨将上面那条最简化路径叫做路径1,下面的叫路径2,先看下用户的选择,有多少用户选择路径1完成购买,数据的结果大概是50%,也就是选择路径1和路径2的用户几乎相等;再看看下从“确认订单”到“完成支付”的转化情况,这是两条路径都有的转化,数据显示路径1的转化率要比路径2高了30%,可以看到选择路径1的用户具有更加明确的目的性,就是为了完成购买;那是不是如果只提供路径2一种选择,那些有明确购买目的的用户即使走路径2也会产生跟路径1一样的转化质量呢?这个显然是不可能的,一旦转化步骤多了一步,肯定会多多少少伴随着部分用户的流失,数据显示如果只提供路径2,整体转化率要比提供两条路径低了20%左右,所以对于这个案例,提供两条转化路径对于整体转化率的提升上显然是有效的。

当然每个数据分析的结果都是以运营环境及产品业务的特征为基础的,在不同的商业模式下完全相同的分析指标可能得到的是完全不同的结果。所以需要对以上数据的环境做个说明:移动互联网的网络环境使用户多请求一个页面的成本相对较高;产品的规格比较统一,差异性小,质量比较稳定;运营的商品价格较低,对于用户而言购买的风险相对较低。

现在再来回答上面的问题——商品详情页面是不是必需的?用户总是在寻求最简单有效的实现途径来降低成本,但同时也会担心风险的存在,而不同的用户对待风险的态度又会有所不同,诸如上述的运营环境,当风险相对较小时,会有相当一部分用户选择最简化的转化途径来满足自身的需求,同时那些较为严谨的用户也有更多的选择来屏蔽风险。所以转化路径的多样化指的是根据自身产品和业务的特征,定制多种的转化路径来满足不同用户的需求。假设卓越首页也上加上这样的“立即购买”按钮,不知道会有多少用户会选择去点击这些按钮:

最后总结起来无非就是一句话:给用户更多的选择。还是以用户中心的理论,不要因为网站自身的需要而给用户造成额外的麻烦和负担,给用户更多的选择和自由,只要用户参与进来了,就是在为网站创造价值,而网站存在的本质无非就是体现其应有的价值。

前面的一篇文章——

前面的一篇文章——