在分析数据的时候,总有那些一些数据异常无法找到适当的理由进行合理解释,也许可以换个角度来看待这些异常。为什么明明数据发生较大的起伏波动,我们绞尽脑汁还是无法找到合理的原因,这些到底是怎么样的异常,是不是存在一些共性,或者这些异常是不是我们平常所说的异常,抑或是应该归到其他类别,不妨先叫它们“难以解释的异常”。

在分析数据的时候,总有那些一些数据异常无法找到适当的理由进行合理解释,也许可以换个角度来看待这些异常。为什么明明数据发生较大的起伏波动,我们绞尽脑汁还是无法找到合理的原因,这些到底是怎么样的异常,是不是存在一些共性,或者这些异常是不是我们平常所说的异常,抑或是应该归到其他类别,不妨先叫它们“难以解释的异常”。

近段时间在读《思考,快与慢》这本书,作者卡尼曼的观点似乎可以给我们一些答案。卡尼曼是心理学和决策学方面的大师,他告诉我们如何避开大脑思考的误区,从而更加理性地进行认知和决策。这里引述书中提及的与上面“难以解释的异常”这个问题相关的两个观点:

- 回归均值效应:事物会经历好坏的随机波动,但最终会回归到平均水平。

- 用因果关系解释随机事件:人们总是试图为一些变化寻找可以解释的原因。

迪马特奥和贝尼特斯

对于回归均值效应(Mean reversion),卡尼曼举了一些与体育相关的例子,确实这个现象在体育竞技中较为常见:高尔夫球手为什么第二天无法打出前一天的好成绩,球员为什么第二个赛季无法复制前一个赛季的辉煌……这让我联想到了近期切尔西的换帅事件。

其实迪马特奥和贝尼特斯之间存在一些有趣的共同点:1) 都是欧冠的冠军教头,2) 能力都没有被完全认可。如果说迪马特奥是没有足够的时间来证明自己的执教能力情有可原的话,那么贝尼特斯显然是自己的选择造成了外界对其能力的质疑。

迪马特奥在上赛季中后段从助理教练接手切尔西,并以看守主教练的身份一路过关斩将,最终夺取欧冠冠军,成功带回球队历史上第一座大耳朵杯足够让其能在赛季末被扶正,但因为缺乏执教经验始终无法让挑剔的老板对其有足够的信任,于是当球迷和俱乐部还沉浸在上赛季欧冠的荣耀光环下,而球队的表现却无法延续“应有”的辉煌时,迪马特奥下课的命运是注定的。在竞争如此激烈的英超联赛,切尔西无法摆脱回归效应,如果说上个赛季切尔西在诸多有利因素的共同作用,再加上一些运气成分的基础上成功加冕欧冠的话,那么这个赛季这些有利因素不再集中地作用于他们,而他们的运气也似乎“用完了”,成绩回归之前的平均水平实属正常现象,而在昔日光环下的球迷和俱乐部显然认为这是“异常事件”,于是迪马特奥成为了回归效应的受害者。

迪马特奥在上赛季中后段从助理教练接手切尔西,并以看守主教练的身份一路过关斩将,最终夺取欧冠冠军,成功带回球队历史上第一座大耳朵杯足够让其能在赛季末被扶正,但因为缺乏执教经验始终无法让挑剔的老板对其有足够的信任,于是当球迷和俱乐部还沉浸在上赛季欧冠的荣耀光环下,而球队的表现却无法延续“应有”的辉煌时,迪马特奥下课的命运是注定的。在竞争如此激烈的英超联赛,切尔西无法摆脱回归效应,如果说上个赛季切尔西在诸多有利因素的共同作用,再加上一些运气成分的基础上成功加冕欧冠的话,那么这个赛季这些有利因素不再集中地作用于他们,而他们的运气也似乎“用完了”,成绩回归之前的平均水平实属正常现象,而在昔日光环下的球迷和俱乐部显然认为这是“异常事件”,于是迪马特奥成为了回归效应的受害者。

其实这类事件在足球界屡见不鲜,世界杯的98法国,02五星巴西,06意大利都难逃回归效应,夺冠之后成绩下滑,而很多教练也在夺冠之后纷纷辞职,因为他们也明白再续辉煌(摆脱回归效应)是如此之难,斯科拉里、里皮等都做出了明智的选择,而这些冠军球队的替任教练又往往是命运最为坎坷的,毕竟能像博斯克这样让西班牙不断延续辉煌的教练真的不多,而贝尼特斯恰恰当了回悲催的替任者。

2010年贝尼特斯接替穆里尼奥成为三冠王国际米兰的主教练,三冠王的光环太过耀眼,而阵容老化加引援不利,注定让国米走上回归效应的道路,于是赛季不到半程,贝帅即被解雇。其实贝尼特斯之前执教生涯的战绩并不是太差,成名于疯狂的“伊斯坦布尔之夜”,但也正是因为这传奇一战成了一座无法逾越的丰碑,即使之后帮助利物浦夺得诸多赛事的冠亚军,也无法让俱乐部和球迷真正的满意,而贝帅的决策失误在于其没有在任何一个辉煌或几近辉煌(07年虽然被米兰复仇雅典,但至少也是个欧冠亚军)的时刻选择退出,直到最后利物浦战绩实在看不下去了才以失败者的身份离开。贝帅真的应该向老辣的银狐里皮或者狡猾的穆里尼奥学习下什么叫做功成身退。

而这次,贝帅又一次选择了欧冠冠军光环下的切尔西,尽管这个光环已渐渐褪去,我们也只能祝他好运了。

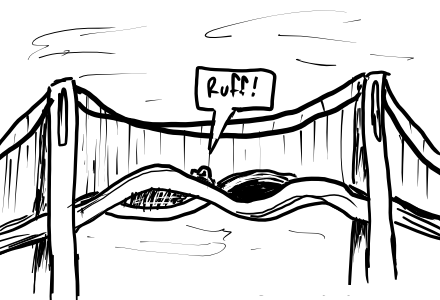

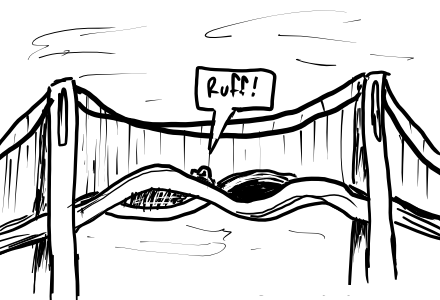

倒塌的桥梁与突然安静的教室

共振(Resonance)催生了宇宙大爆炸,形成了星辰日月和世间万物,共振现象是自然界最普遍的现象之一。一群士兵骑马通过法国昂热市的某座桥时,共振现象导致了桥梁的倒塌,这个例子被引入初中物理教科书,从而成为了我们认识共振原理的启蒙记忆。但是什么原因引发了共振,进而发生桥梁倒塌这类异常事件,正常情况下同样一群士兵同样行军通过同样的桥,可能几万次中才会出现一次桥梁倒塌,士兵是普通的士兵,桥是正常的桥,产生共振完全是一个随机事件,但正是因为这类事件概率太小,所以人们总是试图从士兵或者桥的身上找原因(但是有时候确实是因为桥存在问题 ;- ) )。

共振(Resonance)催生了宇宙大爆炸,形成了星辰日月和世间万物,共振现象是自然界最普遍的现象之一。一群士兵骑马通过法国昂热市的某座桥时,共振现象导致了桥梁的倒塌,这个例子被引入初中物理教科书,从而成为了我们认识共振原理的启蒙记忆。但是什么原因引发了共振,进而发生桥梁倒塌这类异常事件,正常情况下同样一群士兵同样行军通过同样的桥,可能几万次中才会出现一次桥梁倒塌,士兵是普通的士兵,桥是正常的桥,产生共振完全是一个随机事件,但正是因为这类事件概率太小,所以人们总是试图从士兵或者桥的身上找原因(但是有时候确实是因为桥存在问题 ;- ) )。

然后是一个在知乎上看到的问题:为什么原来大家都在讨论,声音嘈杂的教室会突然安静下来?这个也许大家都遇到过,也是一个类似的小概率事件,教室里每个人都在断断续续地说话,正常情况下声音的大小总是保持在一个水平波动,但可能突然有一个时刻同时说话的人数减少了,声音也随机地波动到了一个最低点,这个时候大家就会认为是不是发生了什么事情,老师来了?于是纷纷不说话,教室突然鸦雀无声,一片寂静。大家都感觉到了教室声音的“异常”,而试图为这个异常寻找可能的原因。

什么造成了这些“异常”

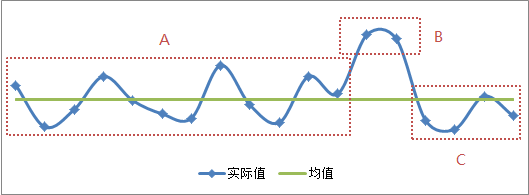

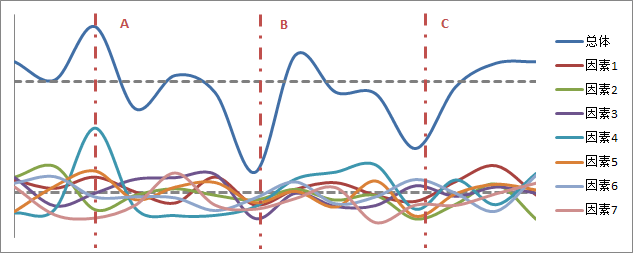

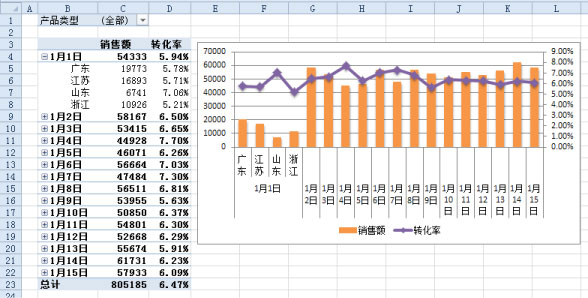

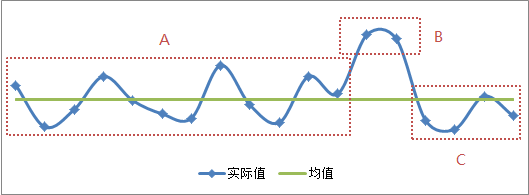

首先来看回归均值效应,一般表现为事物在某段时间表现得非常好,之后回归到正常水平的一个过程。这个按理来说是一个正常的过程,因为事物在诸多因素的共同影响下总有一些随机的波动,关键在于人们总是希望好的状态能够延续,而当事物从一个极好的状态出现下滑时,因为落差较大,所以很容易把回归均值之后的状态当做一种“异常”。如下图:

A段的曲线即使有上下波动,但一般不会被认为有异常,但C段曲线很容易被误认为是异常,因为我们很容易将C段与B段进行比较,而不是A段的均值水平(绿线所示,C段与A段均值差异并不大)。因为这里给出了完整的曲线变化趋势,所以犯这种错误的可能性会降低,但当我们比较短时间内的数据变化,或者简单看数据同环比的时候,就很容易误把回归均值当做一种异常。所以分析数据要结合长期趋势,当事物状态未发生质变而数据明显上升一个台阶的情况下,不要认为好的数据表现总能够持续,因为好的数据表现也只是一个正常的随机波动引起的。

解释了回归均值效应,还需要搞清楚的是虽然事物大部分时间都有小幅的随机波动,但偶然也会出现较大的波动,即极好或者极差的状态,正如上图的B段状态,我们如何认定这个状态也是随机的,而不是异常呢,不能因为难以解释而不把过大的数据波动当做一种异常来看?

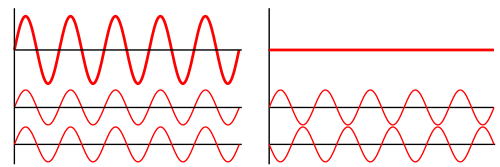

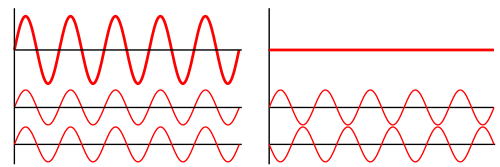

这个问题还是可以从物理学的角度开始解释,先看下波的叠加原理(Superposition Principle):

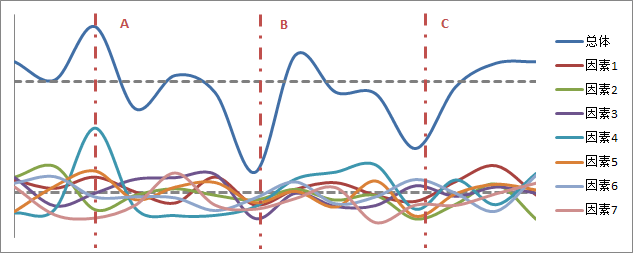

左图的下面2个波在叠加之后合成了更大的振幅,而右图的下面2个波相互干涉,合成后振幅消减为零。引申到数据变化的情境下,一般一个指标会受到多个因素的影响,比如网站的访问量会受多个渠道数据波动的影响,搜索引擎、外部链接、社交媒介、付费广告等这些外部渠道带来的流量总是在变化的,如下图:

当某个渠道的流量异常的时候,如A线所示,或者由于外界因素的影响,如春节或节假日所有渠道的流量都可能普遍下降,如B线所示,这些都可能导致总体访问量的异常,这些异常是可以解释的。C线中每个渠道的数据都未出现明显异常,但由于多个渠道的流量因为随机波动碰巧同时都到了一个较低的点,这个时候总体访问量也会出现明显低于正常水平的情况,于是就出现了“难以解释的异常”。

所以,这些“难以解释的异常”之谜可以揭晓了,当很多因素同时作用于某个指标的时候,即使所有的影响因素都没有出现显著的异常,指标数据仍然可能表现异常,虽然这个概率非常低,但确实会发生,这是因为多个因素共同作用下的叠加效应导致的,如果通过细分指标的影响因素没有发现明显的异常,那么不要试图为这个“难以解释的异常”寻找看上去可以解释的原因。

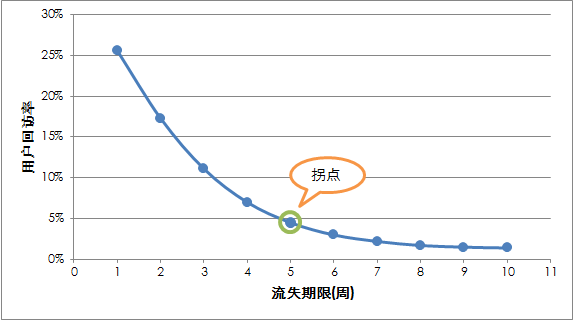

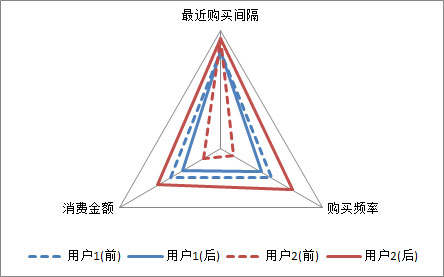

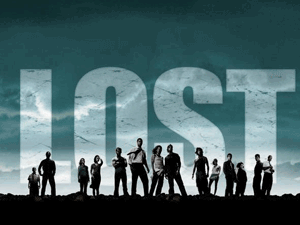

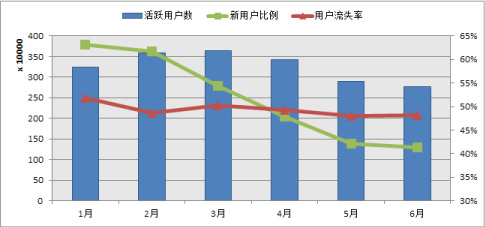

很久没有更新博客了,这篇再写一些关于“用户流失”的内容。之前发布的网站的活跃用户与流失用户这篇文章对网站的活跃用户、流失用户及新用户流失做了定义,这里修正下对流失用户的英文叫法,一般对流失用户常用的英文为“churn user”,之前用的wastage、away、lost等都不是太规范。后来陆续有做相关分析的朋友问到流失用户的流失时间长度到底选择多长是合理的,尤其是《网站分析实战》这本书出版之后,我在里面有提到如何更准确地定义流失的时间长度,可能解释的比较简单,还是有朋友留言反馈这方面的问题,所以这里再用一篇文章解释一下。

很久没有更新博客了,这篇再写一些关于“用户流失”的内容。之前发布的网站的活跃用户与流失用户这篇文章对网站的活跃用户、流失用户及新用户流失做了定义,这里修正下对流失用户的英文叫法,一般对流失用户常用的英文为“churn user”,之前用的wastage、away、lost等都不是太规范。后来陆续有做相关分析的朋友问到流失用户的流失时间长度到底选择多长是合理的,尤其是《网站分析实战》这本书出版之后,我在里面有提到如何更准确地定义流失的时间长度,可能解释的比较简单,还是有朋友留言反馈这方面的问题,所以这里再用一篇文章解释一下。![]()