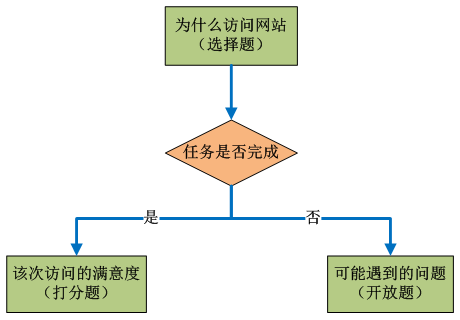

从网站的用户层面,我们根据用户访问的行为特征将用户细分成各种类型,因为用户行为各异,行为统计指标各异,分析的角度各异,所以如果要对用户做细分,可以从很多角度根据各种规则实现各种不同的分类,看到过有些数据分析报告做了各种用户的细分,各种用户行为的分析,再结合其他各种维度,看上去内容绝对足够丰富,但很难理解这些分析结果到底是为了说明什么问题,也许作为一个咨询报告反映当前整体的趋势和用户特征确实合适,但如果真的要让数据分析的结果能够引导我们去做些什么,还是要在做用户细分前确定分析的目的,明确业务层面的需求。

从网站的用户层面,我们根据用户访问的行为特征将用户细分成各种类型,因为用户行为各异,行为统计指标各异,分析的角度各异,所以如果要对用户做细分,可以从很多角度根据各种规则实现各种不同的分类,看到过有些数据分析报告做了各种用户的细分,各种用户行为的分析,再结合其他各种维度,看上去内容绝对足够丰富,但很难理解这些分析结果到底是为了说明什么问题,也许作为一个咨询报告反映当前整体的趋势和用户特征确实合适,但如果真的要让数据分析的结果能够引导我们去做些什么,还是要在做用户细分前确定分析的目的,明确业务层面的需求。

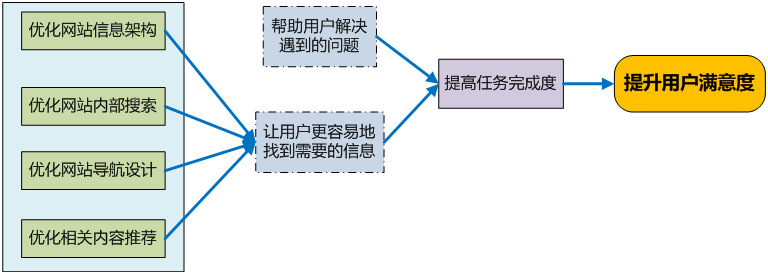

既然要做基于用户细分的比较分析,自然是为了明确某些用户分类群体的行为特征与其他用户群体的差异。这里主要从指导内容层面的调整为导向,通过比较各用户细分群体对内容需求的差异,优化内容运营,将优质的内容或者符合用户偏好的内容推荐给相应的用户。

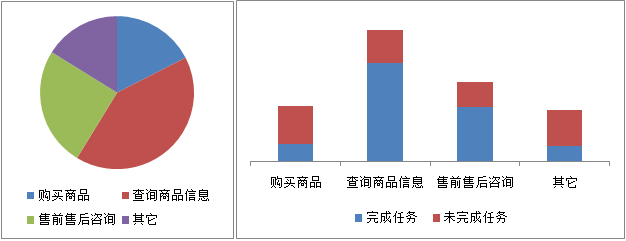

既然是基于用户细分,首先明确用户的细分规则,这里举例3类细分:流失用户与留存用户、新用户与老用户、单次购买用户和二次购买用户,基于这3类细分,对每个分类的用户购买商品进行比较分析,明确哪些商品更加符合用户的预期。

流失用户和留存用户比较

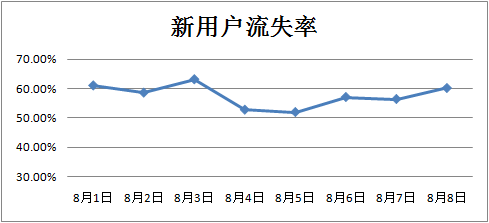

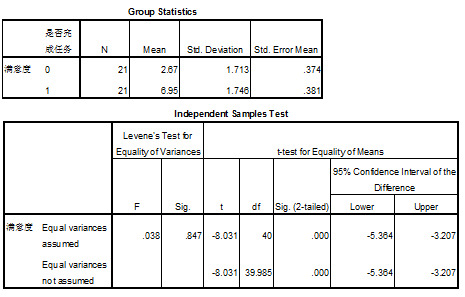

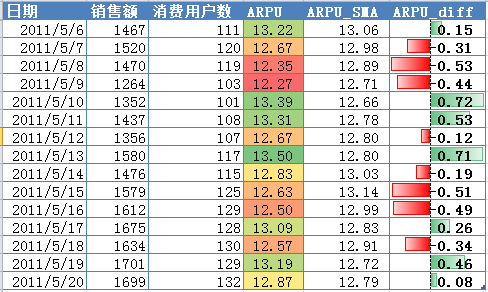

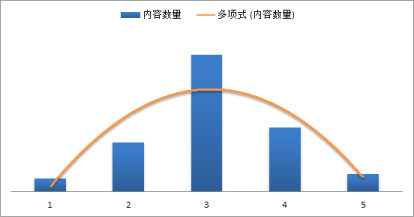

当然,要区分流失用户和留存用户,首先必须对用户流失有一个明确的定义,关于流失用户的定义可以参考博客之前的文章——网站的活跃用户与流失用户。有了定义我们就可以做统计和细分了,还是以电子商务网站为例,电商网站的内容就是商品,我们基于每个商品计算购买这些商品的用户中购买后造成流失的用户比例,如下:

这里的指标定义应该比较明确,每个商品的流失用户比例应该是购买该商品后流失的用户数在所有购买该商品的用户中的占比,但只知道每个商品的流失用户比例无法评价这个商品是否对用户保留有促进作用,或者在一定程度上造成了用户的流失,只有通过与总体水平的比较才能得出相应的结论。所以这里需要重点解释的是“与总体比较”这个数值是怎么计算的到的,这里的百分比不是直接相减的结果,而是一个差异的幅度体现,这里假设总体用户流失率为56%,那么以A商品为例,与总体比较的结果是:( 58.13% – 56% ) / 56% = 3.80% ,使用同样的计算方法也可以得到其他商品与总体比较的差异幅度。最后就是展示,在Excel里面通过“条件格式”里面的数据条功能可以直接展现出图中的效果,非常方便。

很明显,上面图中的分析结果对运营调整有直接的指导性,目的是促进用户保留,所以我们要做的就是将有利于用户留存的商品(F商品的用户流失率明显要比总体低得多,说明F产品更有利于用户保留)推荐给用户,而将那些可能导致用户流失的商品(C商品)进行优化或者下架。

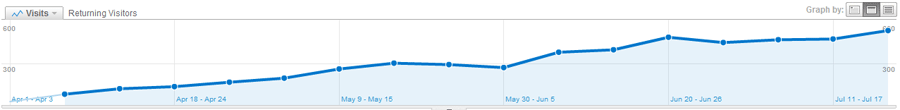

新用户和老用户比较

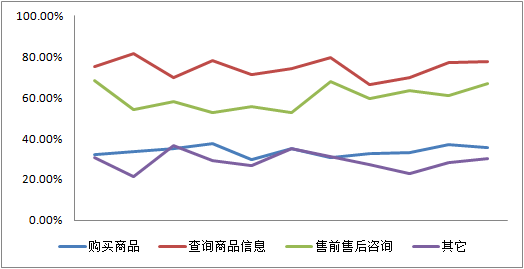

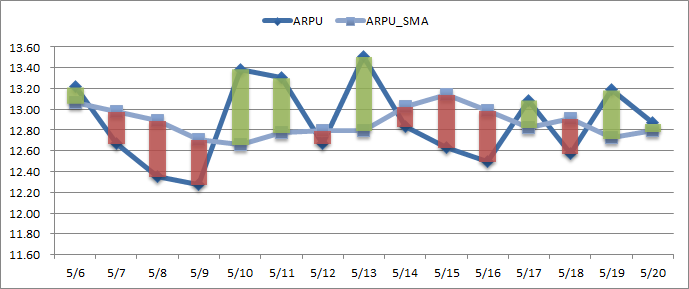

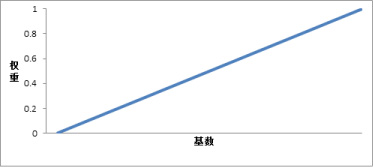

同样,使用上面的方法可以区分不同用户群的购买偏向。新老用户的细分是最常见的用户细分方法,我们可以使用类似的方法来看看新老用户对商品的不同喜好:

从上图中你看出了什么?购买D商品的用户中新用户的比例明显偏低,也许新用户根本就不喜欢这个商品,而B商品和F商品显然更加符合新用户的口味。如果你的网站可以进行新老用户区分的定向推广,那么上面这个分析结果将让你受益良多。

当然,这个数据呈现的特征可能跟商品的推广渠道有一定的关系,比如上图的D商品比较多的是使用老用户比较集中的推广渠道(比如EDM),那么自然购买用户中老用户的比例会偏高;或者把某些商品放在新用户比较集中的Landing Page中展示,那么购买该商品的新用户比例也显然会偏高。所以,在做诸如此类的分析时需要注意根据推广渠道的差异,具体问题具体分析,不能一概而论。

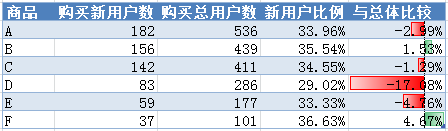

单次购买用户和二次购买用户比较

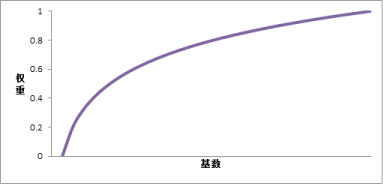

使用同样的方法也可以促成用户的多次购买。对于电子商务网站而言,用户的首次购物体验非常重要,这将会直接影响用户是不是会产生再次或者之后的多次购买,或者是否能够成为网站的忠诚客户。如果你的网站注重用户关系管理,那么你可以尝试下使用下面的分析方法:

需要注意的是这里的基础用户群设定在了每个商品的首次购买用户(不是所有),我们要分析的是所有将该商品作为首次购买商品的情况下,用户是否还会发起之后的再次甚至多次购买行为,从而评价商品对于首次购买体验的影响好坏。从上表可以看出,B商品和F商品在促成二次购买的表现不佳,很有可能商品的使用或质量问题影响了用户的满意度,阻碍了用户再次购买的脚步。根据分析结果,我们尤其需要对那些二次购买率比总体水平低非常多的商品进行重点关注,同时也需要根据商品的特征进行分析,有些商品确实比较容易促成二次购买,因为可能存在交叉销售和向上营销的情况。

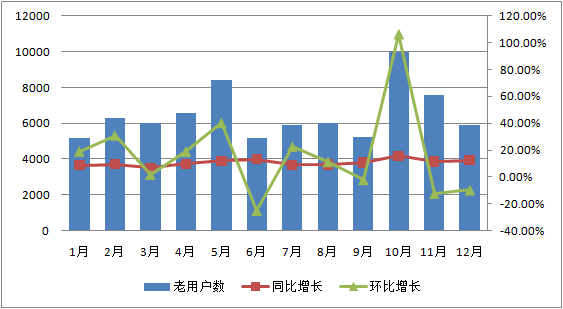

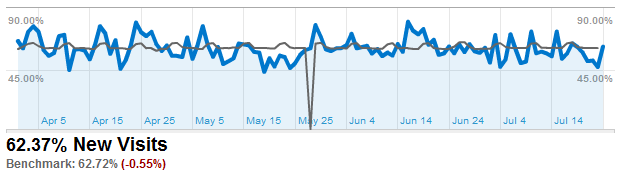

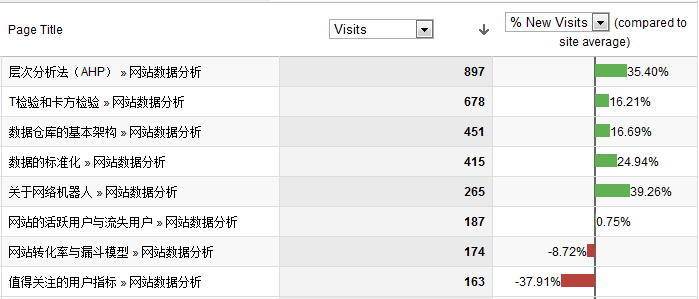

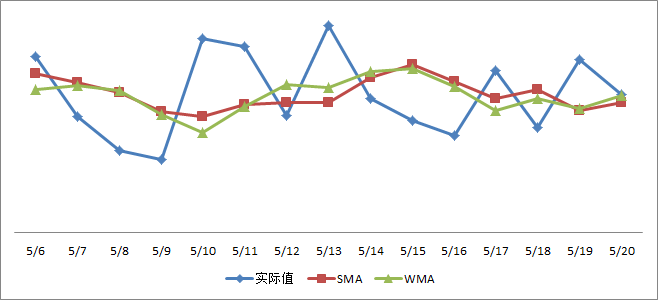

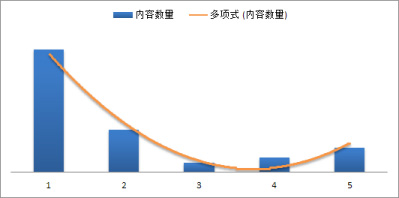

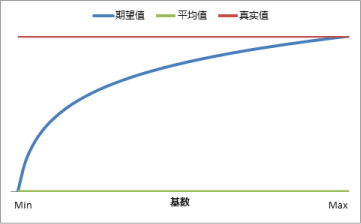

其实本来想把这篇文章拆分成多篇整成一个系列专题,因为从实现层面而言,每一块的用户细分的分析都需要独立完成,而且大部分要从底层的数据计算得到,如果你从Google Analytics上面从寻找类似的数据,其实唯一可以找到的就只有新访问比例,而且在内容模块里面细分到每个页面的指标也未包含% New Visits(在流量来源、地域细分里面有该度量),当然你可以自定义报告来查看网站每个页面的新访问比例,比较的基准还是网站总体的新访问比例,GA的展现方式选择里面直接提供了与总体比较的视图“Comparison”,下图是我做的自定义报表:

GA上面的展现的效果跟用Excel 2010上面定制条件格式后的效果很像(2010可以展现正负值在坐标轴左右侧区分的红绿数据条,2007貌似还未实现此功能),这种基于基准的比较展现非常直观使用,其实在其它的分析中同样可以用到。那么你从我的博客的各内容新用户比例比较分析中看出了什么?访问数排在前几名的文章中很明显的趋势就是概念性方法论的文章新用户比例高于均值(当然主要靠搜索引擎的帮忙),而观点性和分析性的文章的新用户比例低于均值(老用户更偏向于实践和应用 ![]() ),所以如果我的博客可以动态向新用户和老用户展现不同的内容,那么这个分析将十分具有价值,也许你的网站可以尝试下。

),所以如果我的博客可以动态向新用户和老用户展现不同的内容,那么这个分析将十分具有价值,也许你的网站可以尝试下。

最后还是回到一开始的问题,需要总结的是:细分是用于比较的,比较是为了反映差异进而做出调整优化的,所以细分的目的最终还是指导运营决策,这个才是数据分析的价值体现。

前面的一篇文章——

前面的一篇文章——