网站中新老用户的分析已经成为了网站分析中常见的一类用户细分的方法,也是网站分析中用户分析的一个重要组成。Google Analytics中对新老用户的命名分别为New Visitors和Returning Visitors,同时也为许多的分析指标提供了基于新老用户的细分。

网站中新老用户的分析已经成为了网站分析中常见的一类用户细分的方法,也是网站分析中用户分析的一个重要组成。Google Analytics中对新老用户的命名分别为New Visitors和Returning Visitors,同时也为许多的分析指标提供了基于新老用户的细分。

简单地说,新用户就是首次访问网站或者首次使用网站服务的用户;而老用户则是之前访问过网站或者使用过网站服务的用户。无论是新老用户都能为网站带来价值,这也是分析的意义所在。

分析新老用户的意义

网站的老用户一般都是网站的忠诚用户,有相对较高的粘度,也是为网站带来价值的主要用户群体;而新用户则意味着网站业务的发展,是网站价值不断提升的前提。可以说,老用户是网站生存的基础,新用户是网站发展的动力,所以网站的发展战略往往是在基于保留老用户的基础上不断地提升新用户数。

所以分析新老用户的意义就在于:通过分析老用户,来确定网站的基础是否稳固,是否存在被淘汰的危机;通过分析新用户,来衡量网站的发展是否顺利,是否有更大的扩展空间。一个着眼现在,一个放眼未来。

新老用户的辨别

对于网站用户的识别,之前写过一篇相关的文章——网站用户的识别,里面主要是在基于点击流日志的基础上提供的4类识别用户的方法,可以作为参考。但对于新老用户的辨别可能根据网站自身的特定而有不同的定义方法。

最常见的一种辨别新老用户的方式就是看该用户之前是否访问过网站,也就是以用户是否首次访问来区分,GA就是使用Cookie来定义新老用户的,即该Cookie之前出现过则该访客为老用户,否则为新用户。这个定义适用于所有网站,但有它不准确的地方,Cookie的删除、用户更换PC等都会造成数据上的偏差。

另一种辨别方式相对准确,但一般只适用于注册登录型网站,即定义首次注册登录的用户为新用户,再次登录的用户为老用户,而不是使用首次访问来辨别。这种区分方式一般以用户ID或用户名来辨别,相对准确,但应用的范围有限。

新老用户分析

网站的目标在于保持老用户,拓展新用户,那么对于网站数据分析上的表现,则是在保持老用户数量的稳定增长的前提下,提升新用户的所占比例。

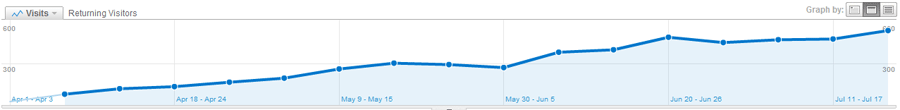

对于大部分发展正常的网站而言,网站的老用户数应该是保持相对稳定的,并且会有持续的小幅上涨,可以看一下GA上我的博客每周老用户数的趋势变化:

可以通过GA的Dashboard上的Advanced Segments选择Returning Visitors,并选择合适的时间区间和汇总粒度(日、周、月)显示趋势变化曲线。这条平滑的上升曲线说明网站的发展是趋于正常的。

但并不是所有网站的老用户趋势都会如此的平滑,比如旅游网站,旅游业会明显地受到季节的影响呈现比较大的波动,所以这里要引入同比和环比的概念进行分析。

同比指的是为了消除季节变动的影响,将本期的数据与去年同期的数据进行比较,比如今年2月的数据与去年2月数据的比较;

环比指的是将本期的数据与前期的数据进行比较,可以是日环比、月环比、周环比等,例如今年2月与今年1月的数据比较。

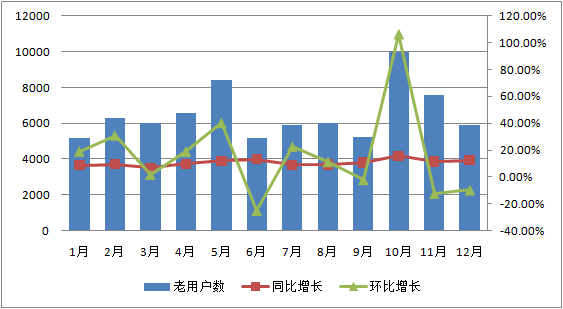

同比和环比被大量地应用于基于时间序列的趋势分析中,对于网站而言,访问量、销售额、利润等网站关键指标同样可以引用同比和环比进行分析,对于分析这些指标的变化趋势,消除季节的影响等都是有积极的效果。下面是一张基于同比和环比的旅游类网站老用户数据模拟趋势分析图:

从图上可以看出由于季节的影响,老用户数的波动比较大,所以相应的环比增长的波动也很大,但同比增长的趋势却相对平滑,一直保持在10%左右的增长率上面,这就可以看出网站对保持老用户是有效的,网站的运营状况较为稳定。

可能有人会问,为什么要用绝对数量,而不是用相对数量,比如老用户占总访问用户的比例来进行趋势分析?这里主要考虑到网站会不定期的进行主动地推广营销,或者由于某些事件或媒体传播的影响而产生的被动推广的效果,这个时候可能会吸引大量的新用户进入网站而导致老用户比例的急剧下滑,而老用户的绝对数据对于网站而言相对稳定,更具参考价值。

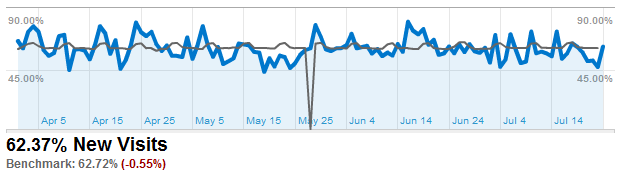

新用户的绝对数量并没有老用户这么稳定,也不一定会保持增长的态势,而对于新用户的分析主要是为了衡量网站推广的效果,评估上述主动营销或被动事件带来的影响,所以不建议使用绝对数值,既然老用户相对稳定,那么就可以基于新用户比例的变化趋势来分析网站某段时间的推广效果。GA的Benchmarking中提供的也是New Visits所占比例与其他网站基准线的趋势比较:

往往曲线中某个时间点的大幅上升或下降都意味着某个营销事件的影响,而当曲线持续下降时就意味着网站推广效果的不利,需要增大推广的力度。

如果你有关于网站新老用户分析更好的见解,欢迎评论。