网站数据分析没有规范的分析流程容易使最后的结果逻辑混乱或者偏离原来的主题,所以一套规范的流程能够使网站分析更加清晰和有效。

网站分析其实就是一个发现问题、分析问题的解决问题的过程。问题的发现可以来源于多方面:网站运营中遇到的问题、用户的反馈和抱怨、日常统计数据的表现异常等;分析问题的过程就是根据遇到的问题运用合理的方法对其进行解释,这也是本站重点探讨的方向;而最后的解决问题则是最为关键的一点,也是目前最被忽视的一点,目前的网站分析工作往往在找到问题后无法落实到寻求最优的解决方案并执行和解决问题这一点上,即使采取了相应的措施也无法进行持续的反馈,并从根本真正地解决问题,很多只是针对一时的举措,而解决问题的过程恰好是最能体现公司执行力的时候,如果没有最终解决问题或者实现优化,那么网站分析就没有丝毫的价值。

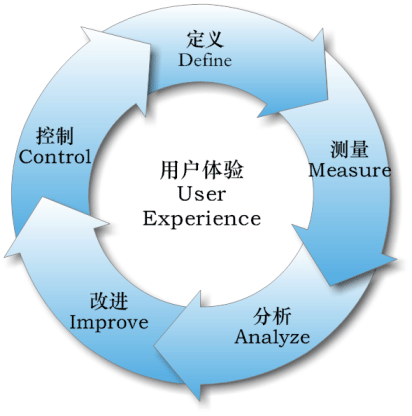

随着互联网的不断发展成熟,网站的发展趋势将更加规范化、精细化,更加注重用户体验,今后的网站建设很重要的一点就是网站的质量管理,所以这里就借用质量管理里面的六西格玛中的DMAIC循环来梳理一下网站数据分析的流程,DMAIC是PDCA质量环的改进,这里将其核心设置为“用户体验”,因为不同网站会有不同的目标,而提高“用户体验”可以说是所有网站的共同目标。

正如上图所示,基于DMAIC循环,网站数据分析的流程也可以用这5步来实现:

定义(Define)

原意是识别和确定用户需求,定义任务的目标和意义。对于网站数据分析来说,可以表述为确定这次分析所针对的问题是什么,分析最终需要达到何种目的,对网站有何实际的意义,同时需要确定分析的范围,及规划本次分析工作的进度和质量控制。

测量(Measure)

原意是收集数据,量化分析。对于网站数据分析来说,同样也是一个收集和获取数据的过程,尽量获得完整、真实、准确的数据,做好数据的预处理工作,便于分析工作的开展。

分析(Analyze)

原意是使用数据统计和分析的方法找到问题的本质。分析不只是对数据的简单统计描述,其结果不应该是一张报表和趋势图这么简单,分析的本质应该是从表面的数据中找到问题的本质,最后需要第一步针对的问题进行归纳和总结。同时需要注意的是分析要紧跟“定义”,不能偏离问题的范围和本质。

改进(Improve)

原意是找到最优的解决方案,是问题得到解决或者使问题的负面影响降到最低。个人认为这一步是最为关键的一步,也是目前很多网站分析工作中较为忽视的一步,很多网站分析只是呈现结果,缺少解决问题的方案,这就相当于找到了管道的漏水点却任由其漏水而不作处理,任何不付诸实践的分析结果都是废纸,毫无意义。同时这一步也是最考验网站执行力的一个步骤。

控制(Control)

原意是监控改进的结果,使相同问题不再重现。这一步无疑是目前最被忽略的一步,很多改进方案实施之后根本不会再去关注反馈情况,而有些改进方案治标不治本,就像网站的访问量无法通过一两次的推广活动通过本质上的提升,关键还在于网站本身的质量,推广活动可能让数据在短期内获得提升,但想要保持长期地增长还是需要不断地优化和改进。所以“控制”要的是持续的反馈和监控,并不断寻找能从最根本上解决问题的最优方案。

所以,网站建设是一个循序渐进的过程,很多网站数据分析也是长期的,不断监视、跟踪并改进,而DMAIC循环也正体现了这个概念,通过不断地网站分析来提高网站质量,提高用户体验。